e-Lettre Climeri-France N°3 - Septembre 2022

L'édito du Conseil Scientifique

Les 3 et 4 février 2022 se sont tenues les journées CLIMERI-France. Elles ont été l'occasion pour la communauté d'échanger autour de différentes thématiques :

- l'actualité autour de CLIMERI, des projets, infrastructures et outils liés et des projets européens,

- les services labellisés, les réflexions en cours sur les atlas de post-traitement ainsi que sur le tuning des modèles,

- les enjeux liés aux évolutions du calcul de haute performance (HPC) - et en particulier les architectures accélérées - et au passage à l'exascale,

- le bilan et les perspectives au niveau français et international des exercices CORDEX (Coordinated Regional Climate Downscaling EXperiment) et CMIP (Coupled Model Intercomparison Project).

Vous avez été nombreux à participer à ces journées pour en faire une réussite et nous vous en remercions.

Le 3ème numéro de la lettre électronique CLIMERI-France est l’occasion de revenir sur certains des sujets qui ont été abordés lors de ces journées ainsi que sur d’autres points d’actualité. Dans ce numéro, les sujets liés à CORDEX, ayant fait l’objet du précédent numéro que vous pouvez retrouver dans la lettre électronique N°2, n’apparaîtront pas dans ce numéro.

Gaëlle Rigoudy et Pascale Braconnot

pour le Comité Scientifique CLIMERI-France

- Pour obtenir la version imprimable de la e-Lettre, cliquez ici.

Outils, projets et groupes de travail

Observer, comprendre et modéliser de manière intégrée l’histoire, le fonctionnement et prévoir l’évolution du système Terre soumis aux changements globaux est un enjeu fondamental de recherche et une nécessité pour de nombreuses applications environnementales et socio-économiques en lien avec la mise en œuvre des objectifs du développement durable.

Observer, comprendre et modéliser de manière intégrée l’histoire, le fonctionnement et prévoir l’évolution du système Terre soumis aux changements globaux est un enjeu fondamental de recherche et une nécessité pour de nombreuses applications environnementales et socio-économiques en lien avec la mise en œuvre des objectifs du développement durable.

Accéder à l’ensemble des données des différents sous-systèmes et milieux est indispensable pour aborder les enjeux de société, qu’ils concernent les risques naturels, l’anthropisation des milieux, le changement climatique, les ressources ou les questions de biodiversité et leurs impacts sur la santé.

Différents systèmes d’information existants, ont été mis en place et rendus facilement accessibles, interopérables et réutilisables par l’intermédiaire des pôles nationaux de données d’observation de l’atmosphère, des océans, des surfaces continentales et de la terre solide (IR DATA TERRA), de biodiversité (IR PNDB) et de simulations climatiques (IR CLIMERI-France). Cependant, le paysage reste fragmenté par domaine, voire par source de données, avec des standards différents et une large gamme de volumes de données pouvant atteindre plusieurs Pétaoctets. Accéder de manière transparente et dynamique à un continuum d'infrastructures interopérables de données et de services distribuées permettant l’extraction, le croisement, l’analyse, la diffusion et l’usage des données et produits dérivés est devenu un enjeu critique pour les sciences du système Terre, de la biodiversité et de l’environnement.

Le projet GAIA Data est porté par ces trois Infrastructures de Recherche numériques, inscrites sur la feuille de route nationale. Il a pour ambition de développer et mettre en oeuvre une infrastructure intégrée et distribuée de données et de services pour l’observation, la modélisation et la compréhension du système Terre, de son climat, de la biodiversité et de l’Environnement. Ce dispositif, basé sur des centres de données et services, interconnectés et pilotés par la science, permettra d’accéder aux différentes sources de données et de disposer d’un continuum de services distribués de stockage (adaptés aux gros volumes de données pour le spatial et la modélisation notamment), de traitements (incluant l’utilisation des moyens de calculs et d’IA), de croisement de données, d’analyse et de visualisation. Des services, adaptés aux besoins des communautés scientifiques, seront proposés sur l’ensemble du cycle de la donnée, de son acquisition jusqu’à ses usages multiples.

L’infrastructure distribuée sera construite autour des principaux centres de calcul et de données des 3 infrastructures de recherche :

L’infrastructure distribuée sera construite autour des principaux centres de calcul et de données des 3 infrastructures de recherche :

- Centres de Calcul Nationaux (CINES, IDRIS)

- Centres de Calcul et données d'organismes (CNES, Ifremer, BRGM, Météo-France)

- Mésocentres Régionaux (GRICAD, UniStra, Univ Lille)

- Mésocentres Thématiques (ICARE, IPSL/ESPRI, IPGP Dante)

Pour répondre au besoin d’accès croisé aux données de ces centres, le projet développera une infrastructure de données et de services au travers de :

- la mise en place d’un réseau dédié haut débit et sécurisé entre ces centres principaux,

- le déploiement d’une grille de données sur ces centres pour permettre un accès distant aux données et le transfert rapide et automatique de grands ensembles de données d’un centre vers un autre,

- une interopérabilité des traitements entre les centres de GAIA Data, ainsi qu’avec les centres HPC en France et en Europe et avec les clouds commerciaux.

- des services communs de découverte, d’accès et de gestion des données d’observation et de modélisation de l’ensemble du système Terre et de la biodiversité,

- la mise à disposition d’accès rapide de traitement et de visualisation des données et produits grâce au développement d’ensembles de données type datacube ou «Anaysis-Ready data»,

- le développement d’environnements virtuels de recherche accessibles au travers d’interfaces web permettant aussi bien la mise au point et l’exécution de codes sur l’infrastructure distribuée, que la soumission de traitements à la demande au travers de systèmes de workflow et d’interfaces type low/no-code.

L’action Equipements structurants pour la recherche du troisième Programme d’Investissements d’Avenir (PIA3) ou ESR/EquipEx+, vise à soutenir de nouveaux équipements d’envergure nationale pour la recherche scientifique. Cette action participe également de la transformation numérique de la recherche et de l’innovation, tout en favorisant les synergies entre les équipes et entre les disciplines mais également entre recherches publique et privée.

Le projet GAIA Data, soutenu par le PIA 3 à hauteur de 16 M€, s’inscrit dans ce double objectif de doter les sciences du système Terre, de la biodiversité et de l’environnement d’une plateforme numérique de données et de services unifiée permettant les études et développements transdisciplinaires. Grâce au soutien des 21 organismes* partenaires du projet, il s’appuie sur les travaux et les expertises des 30 centres de données et services des IR de CLIMERI et PNDB et des pôles nationaux de DATA TERRA (Aeris, ForM@Ter, Odatis, Theia, Dinamis).

*Organismes partenaires du projet GAIA Data : CNRS, CNES, IRD, INRAE, MNHN, BRGM, Ifremer, Sorbonne Université, Météo-France, CEA, IPGP, Université Grenoble Alpes, Université de Strasbourg, CINES, SHOM, Observatoire de la côte d’Azur, IGN, Université de Lille, Université de Toulouse III, CERFACS, IFB. Rédacteurs : K. Ramage (IR DATA TERRA, IPSL), F. Huynh (IR DATA TERRA), S. Joussaume (IR CLIMERI), J-D. Vigne (IR PNDB), R. Moreno (IR DATA TERRA) En savoir plus- Lancement du projet GAIA Data : https://www.data-terra.org/evenement/lancement-gaia-data/

- DATA TERRA : Infrastructure de recherche dédiée aux données d’observation du système Terre

- CLIMERI-France : Infrastructure nationale de modélisation du climat

- PNDB : Pôle National de Données de Biodiversité

- Pôles nationaux de Data Terra

- Aeris : Pôle de données et de services pour l’atmosphère

- ForM@Ter: Pôle de données et services pour la Terre Solide

- Odatis : Pôle de données et de services pour l’océan

- Theia : Pôle de données et de services surfaces continentales

- Dinamis : Dispositif Institutionnel National d’Approvisionnement Mutualisé en Imagerie Satellitaire

Grâce aux ressources et services numériques de l'IPSL (appelés ESPRI), l'infrastructure de recherche CLIMERI-France propose une plateforme d'analyse multi-modèles : ESPRI-Mod. Sur cette plateforme les utilisateurs et partenaires de CLIMERI-France peuvent aujourd’hui accéder à un ensemble de données issues des simulations climatiques globales et régionales de référence qui alimentent les exercices internationaux CMIP et CORDEX dont 1,6 Po de données issues des modèles de l’IPSL, 2,4 Po de données issues des autres groupes de modélisation internationaux, encore appelés replicas. En participant au projet IS-ENES (H2020), ESPRI-Mod a développé un logiciel de réplication des données publiées sur ESGF (Earth System Grid Federation). Ce logiciel effectue des téléchargements parallèles de manière asynchrone permettant ainsi d’atteindre des vitesses de transfert jusqu’à 1TB par jour. Ces données sont ensuite cataloguées en utilisant la librairie “intake-esm” permettant aux utilisateurs de trouver et d’accéder rapidement aux données CLIMERI-France qui répondent aux besoins de leurs analyses.

Au travers du projet GAIA Data, CLIMERI-France renforce en particulier l'accès aux données du CNRM en construisant un lien réseau dédié vers ESPRI. Elle bénéficie aujourd'hui du service JupytherHub afin de faciliter l’exploitation des données issues des simulations climatiques mais également des données d'observation du système Terre (données satellitaires, campagnes, etc.).

Au travers du projet GAIA Data, CLIMERI-France renforce en particulier l'accès aux données du CNRM en construisant un lien réseau dédié vers ESPRI. Elle bénéficie aujourd'hui du service JupytherHub afin de faciliter l’exploitation des données issues des simulations climatiques mais également des données d'observation du système Terre (données satellitaires, campagnes, etc.).

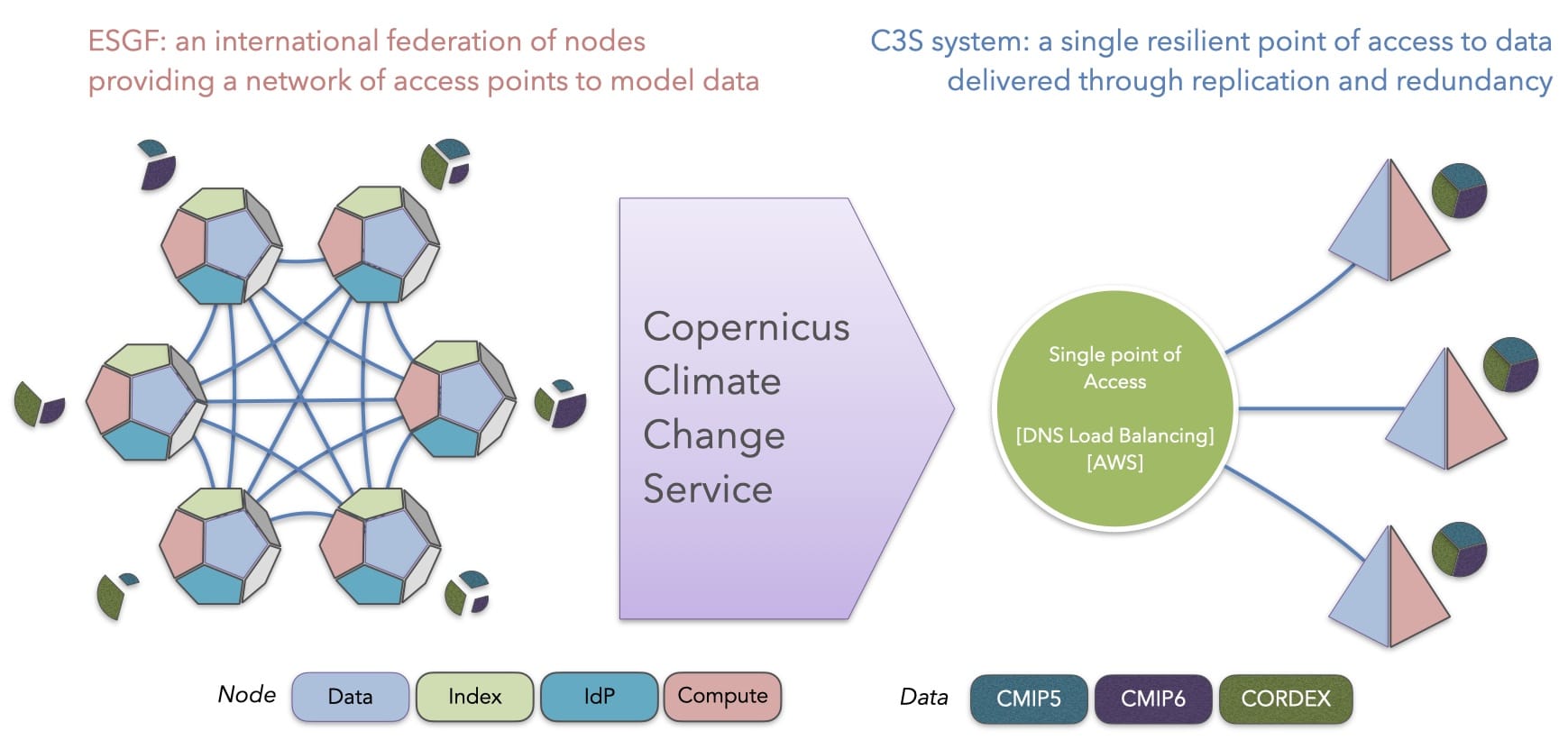

Enfin, CLIMERI-France, via sa plateforme ESPRI-Mod, coordonne depuis le mois de janvier 2022 le projet Copernicus (cf. figure) visant à fournir un sous ensemble de projections climatiques au Climate Data Store du Centre européen pour les prévisions météorologiques à moyen terme (ECMWF).

Rédacteur : G. Levavasseur (IPSL) En savoir plus- CNRM : Centre National de Recherches Météorologiques

- Copernicus : Programme d’observation de la Terre de l’Union Européenne

- CORDEX : Coordinated Regional Climate Downscaling EXperiment

- CMIP: Coupled Model Intercomparison Project

- ECMWF : European Centre for Medium-Range Weather Forecasts

- ESGF : Earth System Grid Federation

- ESPRI : Mesocentre de IPSL pour les sciences du Climat

- ESPRI-MOD

- GAIA Data

- IS-ENES : Infrastructure for the European Network for Earth System Modelling

Le coupleur de codes OASIS3-MCT et le serveur d’IO XIOS ont le vent en poupe, comme le montre le nombre toujours croissant de leurs utilisateurs, tant au niveau français qu’à l’international. Un sondage réalisé en 2019 a montré qu’OASIS3-MCT est utilisé par au moins 67 groupes de modélisation du climat à travers le monde, dont 5 des 7 groupes européens participants à CMIP6, pour assembler plus de 80 modèles couplés. XIOS, pour sa part, est utilisé à l’IPSL et par le groupe CNRM-CERFACS dans le cadre de l’exercice CMIP6 mais aussi par l’IGE, l’Ifremer, le consortium NEMO, le UK MetOffice, l’Université de Reading et le consortium européen EC-Earth.

Plusieurs développements ont été financés récemment dans le cadre du projet européen IS-ENES3 et le Centre d’Excellence ESiWACE2. Une nouvelle version du coupleur, OASIS3-MCT_5.0 a été livrée en décembre 2021. Elle offre en particulier : une interface Python, C et C++ ; une interpolation conservative spécifique pour le ruissellement ; un environnement unifié pour pré-calculer les fichiers de poids d’interpolation avec les librairies SCRIP, ESMF ou XIOS ; un outil intégré de diagnostic d’équilibrage de charge. De plus, la gestion des sources a été migrée de SVN vers GIT, le site web a été mis à jour et est maintenant hébergé au Cerfacs (https://oasis.cerfacs.fr). Enfin, un cours en ligne, un « Short Private Online Course » (SPOC), a été créé et 3 sessions ont déjà été réalisées.

Du côté d’XIOS, une réécriture complète est en cours afin de rationaliser dix ans de divers développements, le but étant en particulier d’améliorer la performance du code, de réduire son empreinte mémoire, mais également d'ouvrir de nouvelles perspectives techniques dans un environnement plus modulaire. Une nouvelle méthode pour gérer les services rendus par XIOS, basée sur le concept de services asynchrones tournant sur des ensembles de processus dédiés, a été introduite et permet en particulier le couplage de codes et le calcul de diagnostics coûteux sur d’autres processus que ceux du modèle client. Une nouvelle version officielle d’XIOS devrait être disponible d'ici la fin du projet IS-ENES3 en mars 2023.

Du côté d’XIOS, une réécriture complète est en cours afin de rationaliser dix ans de divers développements, le but étant en particulier d’améliorer la performance du code, de réduire son empreinte mémoire, mais également d'ouvrir de nouvelles perspectives techniques dans un environnement plus modulaire. Une nouvelle méthode pour gérer les services rendus par XIOS, basée sur le concept de services asynchrones tournant sur des ensembles de processus dédiés, a été introduite et permet en particulier le couplage de codes et le calcul de diagnostics coûteux sur d’autres processus que ceux du modèle client. Une nouvelle version officielle d’XIOS devrait être disponible d'ici la fin du projet IS-ENES3 en mars 2023.

OASIS3-MCT et XIOS bénéficient d’engagements à moyen et long termes de différents instituts. OASIS3-MCT est développé par le CERFACS et le CNRS qui y investissent environ 1 ETP (Équivalent Temps Plein). Du côté d’XIOS, c’est environ 1.5 ETP qui est assuré par le CEA au sein du LSCE/IPSL, avec en particulier un poste permanent à temps plein récemment attribué, appuyé par CLIMERI-France.

A moyen ou long terme, la fusion d’OASIS3-MCT et de XIOS est envisagée afin de ne pas multiplier les outils et de regrouper les forces de travail pour aborder les défis de l’exascale. A court terme, il est prévu de tester et de démontrer l’efficacité des fonctionnalités de couplage de XIOS afin de planifier cette fusion.

Rédactrice : S. Valcke (CERFACS)

En savoir plus- CEA : Commissariat à l’Énergie Atomique

- CERFACS : Centre Européen de Recherche et de Formation Avancée en Calcul Scientifique

- CNRM : Centre National de Recherches Météorologiques

- CNRS : Centre National de la Recherche Scientifique

- CMIP6 : 6th Coupled Model Intercomparison Project

- ESiWACE : Centre of Excellence in Simulation of Weather and Climate in Europe

- ESMF : Earth System Modelling Framework

- IFREMER : Institut Français de Recherche pour l'Exploitation de la Mer

- IGE : Institut des Géosciences de l’Environnement

- IPSL : Institut Pierre-Simon Laplace

- IS-ENES : Infrastructure for the European Network for Earth System Modelling

- LSCE: Laboratoire des Sciences du Climat et de l’Environnement

- SCRIP: Spherical Coordinate Remapping and Interpolation Package

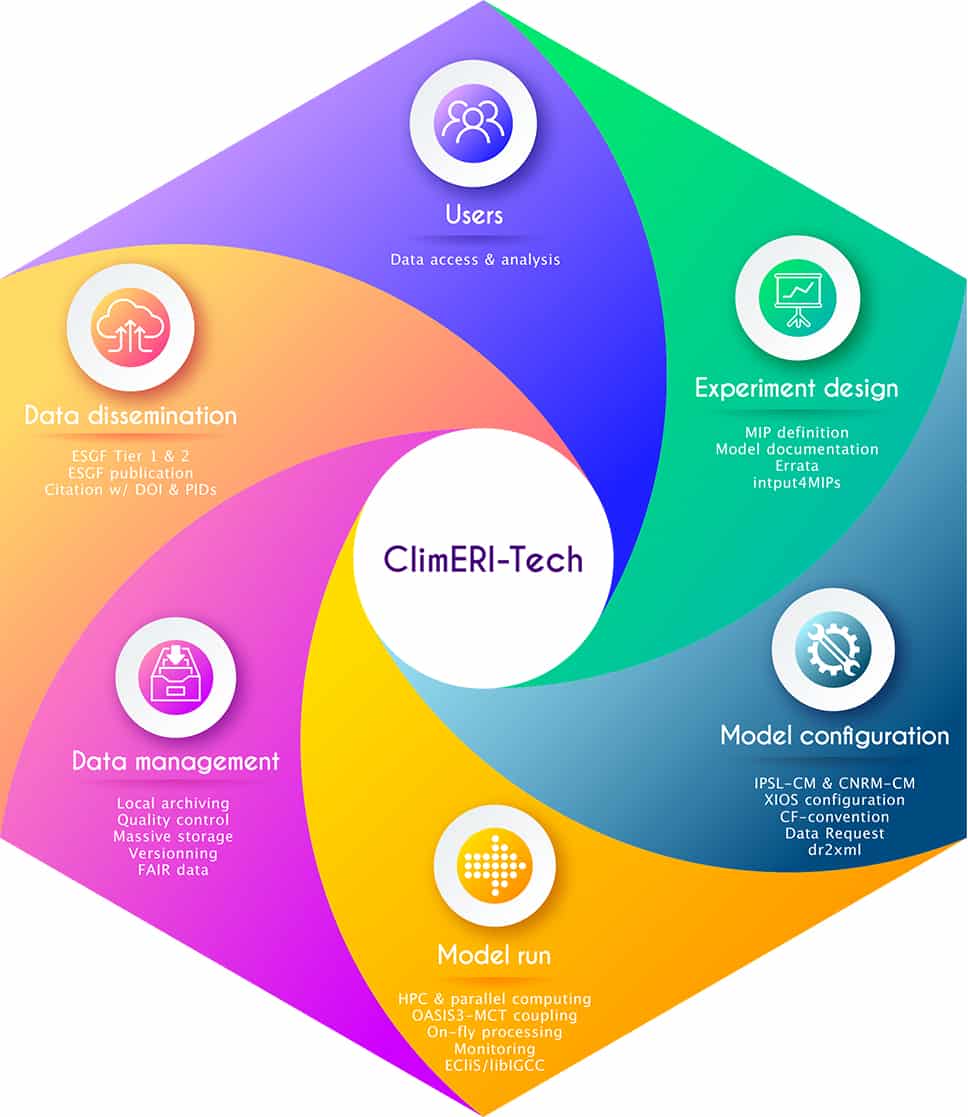

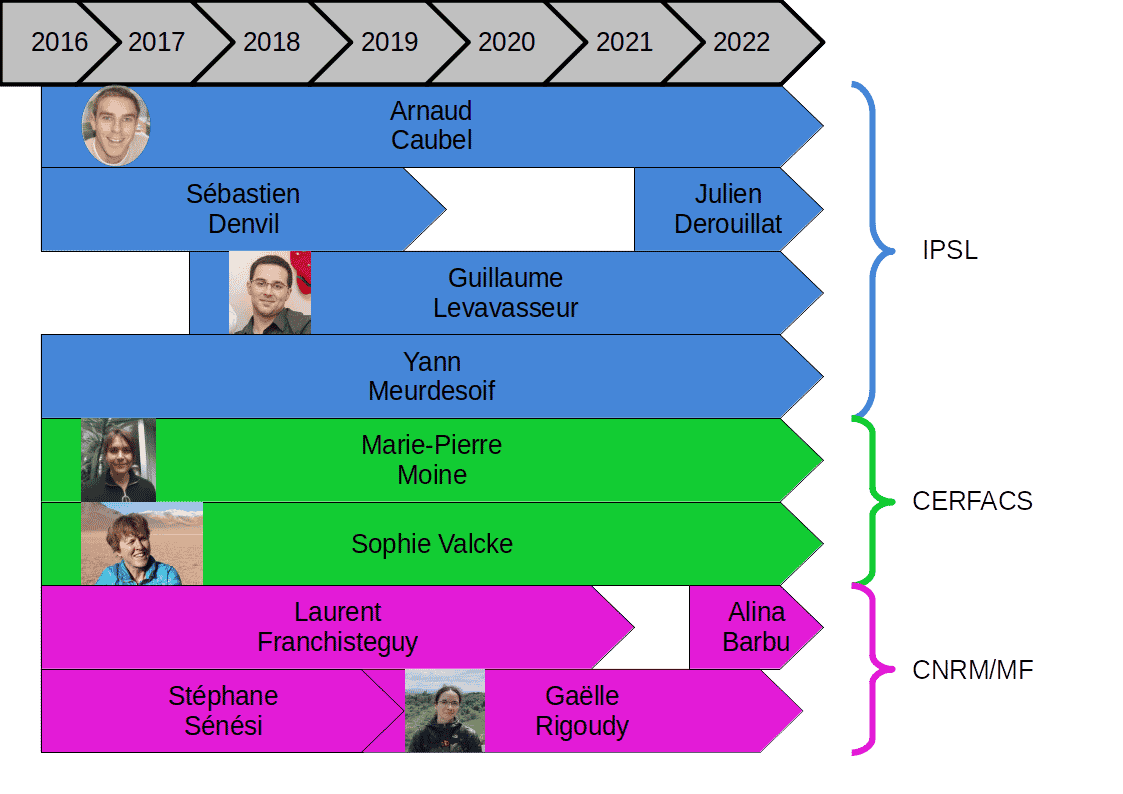

L'exercice CMIP6 a demandé aux groupes de modélisation climatique du CNRM-CERFACS et de l'IPSL un travail de mise au point des modèles et des procédures de production, standardisation, gestion et distribution des données issues des simulations réalisées avec ces modèles. Une collaboration s'est tout naturellement installée entre les ingénieurs impliqués sur ces tâches.

C'est au sein de l'infrastructure nationale de recherche CLIMERI-France que ces ingénieurs ont trouvé un lieu d'échange pour :

- discuter des techniques transverses,

- résoudre des problématiques communes soulevées par la réalisation des simulations CMIP6 françaises,

- mettre en commun leurs expertises.

En se réunissant tous les trimestres, ce groupe a réussi à construire une stratégie commune de production et gestion de données CMIP6 :

- en développant ou adaptant des briques logicielles opérationnelles utilisables dans des environnements de production différents (libIGCM et ECLIS par exemple),

- en évaluant les performances de ces briques,

- en optimisant leur utilisation.

Parmi elles, le serveur d'entrées-sorties XIOS commun aux modèles du CNRM-CERFACS et de l'IPSL a bénéficié de nouvelles fonctionnalités spécifiques pour répondre aux besoins de la production CMIP6. Côté standardisation, la librairie "dr2xml" a été développée pour traduire les pré-requis de la Data Request CMIP6 en fichier de configuration XML pour XIOS. Le coupleur OASIS3-MCT, également utilisé par les deux groupes de modélisation, a aussi donné lieu à des retours d'expériences croisés. Enfin, les outils nécessaires au contrôle qualité, au versionnement et à la publication des données sur ESGF ont été adaptés, en collaboration avec la communauté internationale (CDNOT), pour répondre aux besoins des deux groupes.

Bien que ce groupe de travail, auto-nommé CLIMERI-Tech, soit né afin d'accompagner la réalisation des simulations CMIP6, sa dynamique commune est toujours en place aujourd'hui. Grâce à l'expérience acquise autour du projet CMIP6, les activités du groupe peuvent désormais s'étendre à d'autres groupes de modélisation climatique français réalisant d'autres types de simulations (régionales par exemple).

Rédacteurs : Les membres du groupe CLIMERI-Tech (climeri-tech@listes.ipsl.fr)

En savoir plus

Rédacteurs : Les membres du groupe CLIMERI-Tech (climeri-tech@listes.ipsl.fr)

En savoir plus

La prospective "Océan-Atmosphère" (OA), qui se tient tout au long de l’année 2022, doit permettre à la communauté scientifique concernée, parmi laquelle l’essentiel des forces dans le domaine de la modélisation climatique, de prendre un temps de réflexion collectif sur les avancées scientifiques marquantes et sur les orientations à venir, sur le socle disciplinaire des communautés, mais aussi sur les interfaces avec les autres disciplines.

La prospective "Océan‐Atmosphère" rassemble des scientifiques de tous les organismes, et n’a pas vocation à doublonner les synthèses déjà produites sur des aspects spécifiques ou des régions ou compartiments particuliers. La prospective "Océan-Atmosphère" est également l’occasion pour une communauté de se positionner sur un certain nombre de questions, notamment en lien avec la société, et pour lesquelles la diversité des points de vue de chacun.e nourrira des documents de synthèse utiles pour la prochaine décennie.

La contribution de tous et toutes - chercheur.e.s, enseignant-chercheur.e.s, technicien.ne.s, ingénieur.e.s, doctorant.e.s, post-doctorant.e.s, contractuel.le.s, équipes constituées, groupes de travail informels, programmes, GDR, directeurs ou directrices de laboratoire ou d’OSU, de services labellisés, d’infrastructures de recherche, etc… - est attendue, et la participation aux groupes de travail et colloques de discussion souhaitée.

La prospective "Océan-Atmosphère" est organisée par la Commission Spécialisée Océan-Atmosphère.

L’exercice de prospective "Océan‐Atmosphère" a pour objectifs :

- d’identifier des axes de recherche qui pourraient se renforcer ou émerger à l’échelle des dix prochaines années,

- d’identifier les forces et les faiblesses pour élaborer des recommandations sur les meilleures conditions à mettre en place pour permettre la réalisation des axes de recherche identifiés et leur valorisation,

- d’implémenter en tenant compte des spécificités des communautés "Océan-Atmosphère" de la prospective transverse de l’INSU.

Les objectifs plus détaillés de cette prospective sont décrits sur le site web utilisé pour rassembler les informations et contributions de cette prospective (accessible via une connexion au système d’information du CNRS).

Pour participer, il est possible de :- suggérer des thèmes de travail : du 1er mai à l'automne 2022 sur le site web de la prospective,

- contribuer sur les forums dans une consultation ouverte,

- participer aux groupes de travail prospectifs qui seront ouverts pendant l'été 2022 pour des travaux à la rentrée 2022,

- participer au colloque de la prospective qui aura lieu en janvier 2023.

La prospective "Océan-Atmosphère" 2022 est l’occasion pour la communauté de modélisation climatique, en lien avec les domaines connexes, d’élaborer une synthèse des défis scientifiques et techniques à relever dans la prochaine décennie, des orientations stratégiques pour s’y attaquer, des moyens nécessaires et projets prioritaires à engager, tout en positionnant la communauté scientifique nationale vis-à-vis du contexte scientifique et technique européen et international. Le texte de prospective peut ainsi constituer une référence utile à la communauté et ses instances et organismes. Il contribuera à éclairer les choix et orientations des prochaines années, sur une base d’autant plus robuste que les réflexions seront approfondies et aboutiront à un texte explicitant clairement les enjeux et perspectives les plus pertinentes.

Rédacteurs : T. de Garidel-Thoron (Président de la Commission Spécialisée Océan-Atmosphère) et J.-F. Doussin (Directeur Adjoint Scientifique Ocean-Atmosphère de l'INSU) En savoir plus- Commission Spécialisée Océan-Atmosphère

- Objectifs détaillés de la prospective (accès restreint via une connexion au système d’information du CNRS) : https://extra.core-cloud.net/collaborations/prospective-OA-2022/SitePages/Accueil.aspx

- Prospective transverse de l’INSU

Tuning et services labellisés

Le développement des paramétrisations est un enjeu majeur dans le développement des modèles de prévision numérique du temps et de climat. Des paramètres libres sont présents dans chacune des paramétrisations. La calibration nécessaire de ces paramètres libres est une tâche difficile (grand nombre de paramètres et de métriques, coût numérique des simulations), jusqu’à récemment peu documentée et peu formalisée. Cette étape est classiquement menée sur des métriques du modèle global afin, notamment, d’assurer un bilan d’énergie équilibré à l’échelle globale dans les modèles de climat.

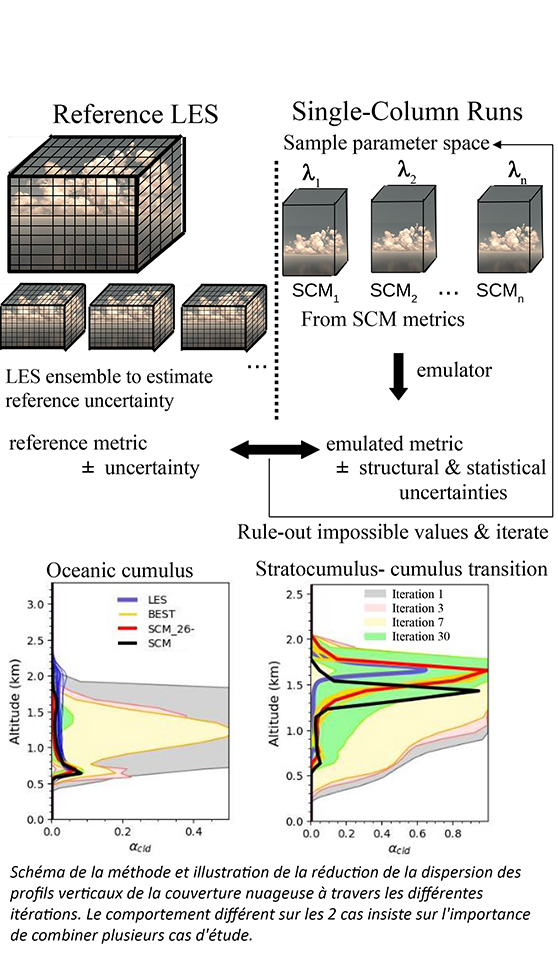

Nous décrivons ici un nouvel outil qui propose une phase de calibration intermédiaire basée sur des grandeurs orientées processus (Couvreux et al, 2021) permettant de limiter au maximum des compensations d’erreurs. Nous ajoutons donc une première étape de calibration qui repose sur la comparaison de simulations uni-colonne (extraction d’une colonne de modèle 3D qui contient exactement le même ensemble de paramétrisations) à des simulations tri-dimensionnelles à haute résolution qui représentent explicitement l’essentiel des processus pertinents et servent donc de référence. Grâce à des méthodes statistiques avancées, l’outil émule à coût numérique quasi-nul la réponse du modèle à calibrer et permet de prévoir la réponse du modèle pour n’importe quelles valeurs des paramètres libres. La comparaison des prévisions statistiques aux simulations de référence en tenant compte des différentes incertitudes associées à la référence, au modèle statistique et à l’erreur structurelle du modèle permet de rejeter toutes les valeurs impossibles de paramètres et de restreindre le domaine des valeurs acceptables de paramètres à explorer lors de l'ajustement du modèle global 3D. Cet outil a été appliqué pour différents usages :

Nous décrivons ici un nouvel outil qui propose une phase de calibration intermédiaire basée sur des grandeurs orientées processus (Couvreux et al, 2021) permettant de limiter au maximum des compensations d’erreurs. Nous ajoutons donc une première étape de calibration qui repose sur la comparaison de simulations uni-colonne (extraction d’une colonne de modèle 3D qui contient exactement le même ensemble de paramétrisations) à des simulations tri-dimensionnelles à haute résolution qui représentent explicitement l’essentiel des processus pertinents et servent donc de référence. Grâce à des méthodes statistiques avancées, l’outil émule à coût numérique quasi-nul la réponse du modèle à calibrer et permet de prévoir la réponse du modèle pour n’importe quelles valeurs des paramètres libres. La comparaison des prévisions statistiques aux simulations de référence en tenant compte des différentes incertitudes associées à la référence, au modèle statistique et à l’erreur structurelle du modèle permet de rejeter toutes les valeurs impossibles de paramètres et de restreindre le domaine des valeurs acceptables de paramètres à explorer lors de l'ajustement du modèle global 3D. Cet outil a été appliqué pour différents usages :

(i) une calibration à l’échelle d’une paramétrisation individuelle (Villefranque et al, 2021),

(ii) une calibration d’une version uni-colonne du modèle de climat du CNRM (Audouin et al, 2021) et

(iii) la succession de la calibration 1D et d’une calibration 3D du modèle global pour le modèle LMDZ (Hourdin et al, 2021).

Cet outil permet de distinguer les limites du modèle dues à une mauvaise calibration de ses paramètres de celles intrinsèques du modèle, liées à son contenu scientifique. Son erreur structurelle peut ainsi être documentée. Il caractérise également la sensibilité du modèle à ses paramètres libres, information importante pour la compréhension de l’incertitude des propriétés émergentes du modèle (e.g., sensibilité climatique). Enfin, il permet aussi de rapidement proposer une calibration à tout nouveau développement de paramétrisations et donc de mener de front calibration et développement de paramétrisation.

Rédacteurs : F. Couvreux (CNRM), F. Hourdin (LMD-IPSL), R. Roehrig (CNRM), N. Villefranque (CNRM & Université Toulouse), C. Rio (CNRM) et le groupe High-Tune

Références

- Couvreux F., F. Hourdin, D. Williamson, R. Roehrig, V. Volodina, N. Villefranque, C. Rio, O. Audouin, J. Salter, E. Bazile, F. Brient, F. Favot, R. Honnert, M.-P. Lefebvre, J.-B. Madeleine, Q. Rodier, W. Xu, 2021: Process-based climate model development harnessing machine learning: I A new tool for parameterization improvement, Journal of Advances in Modeling Earth Systems, 13, e2020MS002217. https://doi.org/10.1029/2020MS002217

- Hourdin F., D. Williamson, C. Rio, F. Couvreux, R. Roehrig, N. Villefranque, I. Musat, L. Fairhead, F. B. Diallo, V. Volodina, 2021: Process-based climate model development harnessing machine learning: II: model calibration from single column to global, Journal of Advances in Modeling Earth Systems, 13, e2020MS002225. https://doi.org/10.1029/2020MS002225

- Audouin, O., R. Roehrig, F. Couvreux, D. Williamson, 2021: Modeling the GABLS4 strongly-stable boundary layer with a GCM turbulence parameterization: parametric sensitivity or intrinsic limits? Journal of Advances in Modeling Earth Systems, 12, e2020MS002217. https://doi.org/10.1029/2020MS002269

- Villefranque N., S. Blanco, F. Couvreux, R. Fournier, J. Gautrais, R. Hogan, F. Hourdin, V. Volodina, D. Williamson, 2021: Process-based climate model development harnessing machine learning: III. the representation of cumulus geometry and their 3D radiative effects, Journal of Advances in Modeling Earth Systems, 13. 10.1029/2020MS002423. https://doi.org/10.1029/2020MS002423

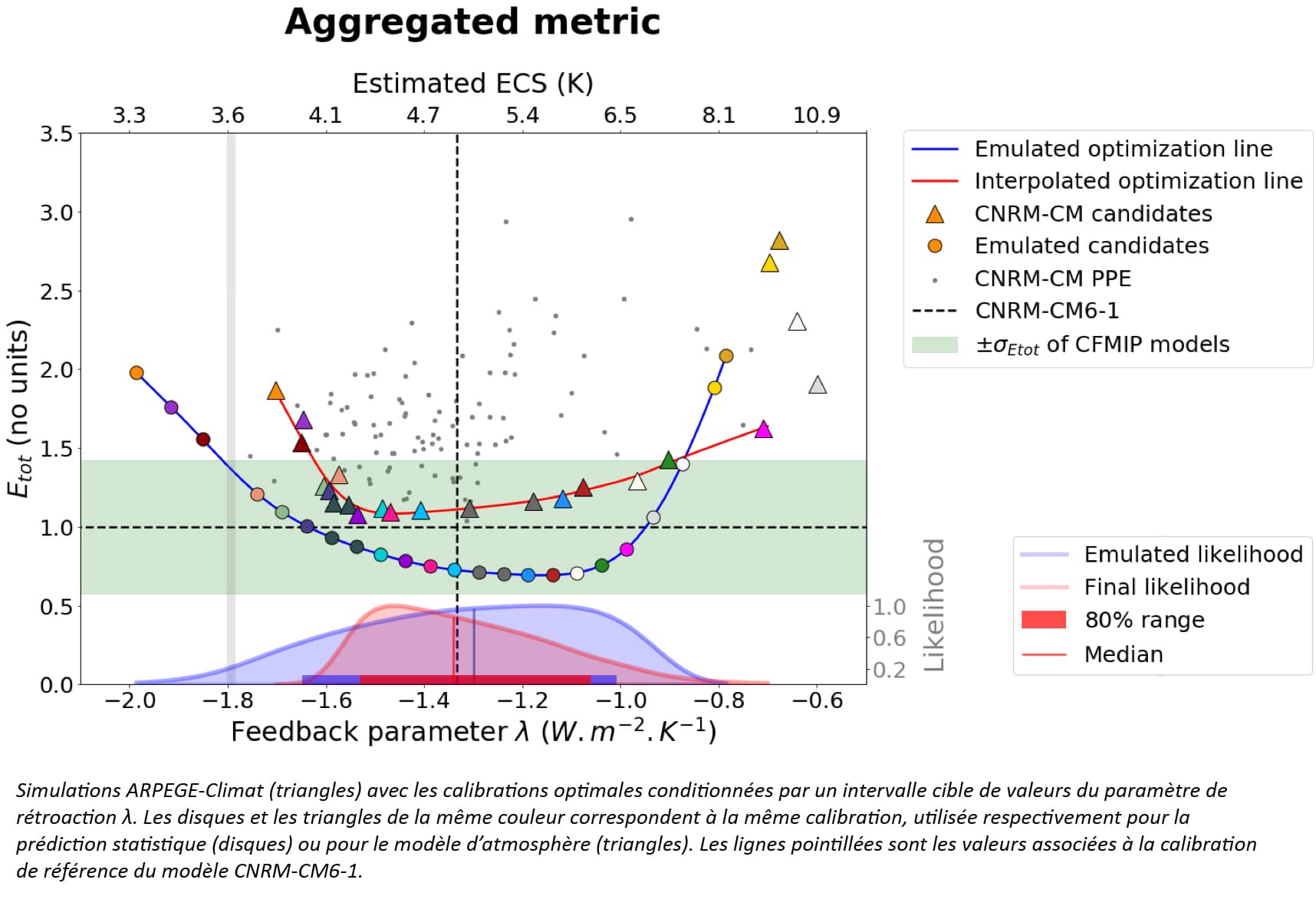

Dans les modèles de climat, et notamment dans leurs composantes atmosphériques, la représentation des processus à fine échelle par des paramétrisations sous-mailles introduit un nombre important de paramètres libres à calibrer. La calibration de ces paramétrisations est souvent basée sur une approche empirique et repose principalement sur le jugement d’experts, bien que des approches de calibrations automatiques ou quasi-automatiques telles que l’History Matching se développent de plus en plus. Cette incertitude de calibration peut affecter la réponse de température de surface globale à un doublement de la concentration en CO2, mesurée par la sensibilité climatique à l’équilibre (ECS). L’impact de la calibration des modèles de climat sur l’ECS est encore peu étudié, représentant une source d'incertitude majeure dans les projections climatiques.

La méthode présentée dans Peatier et al. (2022) a donc pour objectif d’explorer l’intervalle plausible de l’ECS dans un ensemble de simulations atmosphériques avec perturbation des paramètres, appelé PPE, d’ARPEGE-Climat 6.3, la composante atmosphérique du modèle CNRM-CM6-1. L’ECS n’étant pas quantifiable à partir de simulations atmosphériques seules, elle sera estimée linéairement à partir du paramètre de rétroaction climatique λ. Ce paramètre de rétroaction est le rapport entre les différences de budgets radiatifs au sommet de l’atmosphère et de températures de surface entre une simulation de contrôle (amip) et une simulation forcée par une augmentation de 4K de la température de surface des océans (amip-future4K). Le PPE est produit à partir d’un échantillonnage par hypercube latin des valeurs de 30 paramètres physiques ajustables du modèle d’atmosphère. Ces paramètres sont pour la plupart des propriétés radiatives ou microphysiques des nuages, ou des paramètres impliqués dans la convection et la turbulence.

Le PPE comprend 102 paires de simulation et couvre un large intervalle de valeurs de λ, plus large que l'intervalle multi-modèles CMIP6. Cependant, les simulations du PPE ne sont pas toutes aussi performantes à représenter le climat de contrôle et une métrique intégrée de comparaison aux observations doit être définie, utilisée comme un score quantifiant la performance du modèle. Ce score Etot est en fait la moyenne de quatre métriques permettant de comparer les flux ondes longues et ondes courtes au sommet de l’atmosphère, la température de surface et les précipitations avec des observations via une estimation de l’ erreur quadratique moyenne (appelées RMSE). Ces RMSE ne sont cependant pas calculées entre les champs complets des variables du modèles et les observations, mais seulement à partir des champs reconstruits à partir des cinq premiers modes (appelés EOF) de variabilité des moyennes annuelles dans le PPE, estimés grâce à des décompositions par analyse en composante principale.

Ces décompositions permettent principalement de faire de l’apprentissage supervisé (ici avec des régressions linéaires multivariées - MLR) pour prédire, à partir des 30 valeurs des paramètres, les composantes principales des EOF, et donc le score Etot , ainsi que le paramètre de rétroaction . Ces prédictions statistiques permettent d’explorer la gamme des valeurs de λ au sein d’un sous-ensemble de calibrations optimales, identifiées via une optimisation sous contraintes: on découpe la plage des λ en N intervalles et pour chaque intervalle, on cherche la combinaison de paramètres qui va minimiser la métrique Etot.

En dépit de l’approximation introduite par l’utilisation de l’émulation statistique, nous avons pu produire 15 variantes (sous-entendu 15 combinaisons différentes pour les valeurs des 30 paramètres) du modèle qui présentent un score Etot comparable à celui de l’ensemble multi-modèle CFMIP tout en couvrant un intervalle d’ECS de [4.1K – 6.1K]. Un premier résultat important à noter est de constater que malgré ce travail d’optimisation, aucune des simulations candidates n’est plus performante que la calibration de référence, suggérant que l’approche empirique de la calibration du modèle est robuste. Ces résultats montrent également l’impact non négligeable de la calibration du modèle sur le paramètre de rétroaction climatique et potentiellement sur l’ECS, mettant en lumière l’importance de mieux quantifier l’incertitude de calibration dans les projections climatiques.

Rédacteur : S. Peatier (CERFACS) et L. Terray (CERFACS) Référence- Peatier, S., Sanderson, B. M., Terray, L. and Roehrig, R. (2022) Investigating Parametric Dependence of Climate Feedbacks in the Atmospheric Component of CNRM-CM6-1, Geophysical Research Letters, 49 (9), pp. e2021GL095084, doi:10.1029/2021GL095084

Les enjeux du HPC et la préparation à l'exascale

La modélisation du climat dépend de façon critique de l’accès à des moyens de calcul haute performance. Suite à la fin de la loi de Moore et aux exigences de sobriété, la performance est de plus en plus obtenue à partir de machines incluant des accélérateurs. Pour bénéficier des performances de ces machines aux architectures hétérogènes, un travail important d’adaptation des codes, voire de réécriture est nécessaire (voir article de Yann Meurdesoif "L’enjeu des machines accélérées" pour plus de détails sur ces architectures).

L’Europe, en partenariat avec une trentaine de pays membres dans le cadre de la EuroHPC JU (European High Performance Computing Joint Undertaking) lancée en 2018, a une politique très ambitieuse d’investissement massif dans le calcul haute performance et les données, avec l’objectif de renforcer les capacités de simulation, le traitement de données massives ainsi que le développement de l’intelligence artificielle et du quantique. Dans une première phase, en cours d’implémentation, trois machines pré-exascales sont prévues, puis deux machines exascales. La France souhaite se porter candidate pour la 2ème machine exascale européenne pour 2024. Dans ce cadre, un groupe de travail inter-organismes (CNRS, CEA, INRIA et Universités) a été mis en place en 2021 pour recenser les applications et les enjeux posés par l’exascale et plus largement à l’utilisation de machines accélérées.

L’Europe, en partenariat avec une trentaine de pays membres dans le cadre de la EuroHPC JU (European High Performance Computing Joint Undertaking) lancée en 2018, a une politique très ambitieuse d’investissement massif dans le calcul haute performance et les données, avec l’objectif de renforcer les capacités de simulation, le traitement de données massives ainsi que le développement de l’intelligence artificielle et du quantique. Dans une première phase, en cours d’implémentation, trois machines pré-exascales sont prévues, puis deux machines exascales. La France souhaite se porter candidate pour la 2ème machine exascale européenne pour 2024. Dans ce cadre, un groupe de travail inter-organismes (CNRS, CEA, INRIA et Universités) a été mis en place en 2021 pour recenser les applications et les enjeux posés par l’exascale et plus largement à l’utilisation de machines accélérées.

Avec Marie-Alice Foujols (IPSL), nous avons coordonné le groupe de travail « Sciences de l’Univers » incluant astrophysique, sciences de la terre, du climat et de l’environnement mais aussi la physique des hautes énergies et la physique nucléaire. Dans le cadre de CLIMERI-France, le modèle couplé de l’IPSL a fait partie du recensement, en collaboration avec le CERFACS. Si le besoin de performance est important face aux enjeux de résolution, de grands ensembles, de longues simulations et de représentation de la complexité du système Terre, le travail pour adapter les codes va nécessiter de compléter les équipes avec des personnes d’expertises pointues et un important investissement humain sur la durée. La dynamique est lancée, relayée par un groupe de travail mis en place à l’INSU, même s’il reste encore pas mal d’inconnues sur les architectures et la façon d’atteindre de bonnes performances sur ces futures machines.

Cet enjeu est partagé au niveau de la communauté de modélisation du climat en Europe, en particulier dans le cadre du projet européen ESIWACE2. Si le modèle allemand d’atmosphère ICON est déjà porté sur GPU, les anglais ont lancé un important travail de réécriture du code d’atmosphère basé sur la notion de « separation of concern » permettant de séparer la couche informatique des couches de modélisation. Le Centre européen de prévision météorologique à moyen terme a aussi investi fortement sur un programme de scalabilité depuis plusieurs années. La conférence organisée par IS-ENES3 en mai 2022 à Barcelone illustre ces différents exemples et montre l’enjeu important que représente l’évolution des architectures de calcul pour le domaine de la modélisation du climat.

Rédactrice : S. Joussaume (LSCE-IPSL) En savoir plus- ESIWACE2

- European High Performance Computing Joint Undertaking (EuroHPC JU)

- 7th ENES HPC Workshop, 9-11 May 2022 - Barcelone (Espagne)

- IS-ENES : Infrastructure for the European Network for Earth System Modelling

- TGCC : Très Grand Centre de Calcul du CEA

- Y. Meurdesoif - L’enjeu des machines accélérées, E-Lettre CLIMERI-France N°3, Septembre 2022

La réflexion sur l’avenir du calcul haute performance, et les liens entre les simulations, les données générées et leurs multiples utilisations génèrent de nombreuses discussions au niveau international. Le débat a fait apparaître des zones de fractures, que l’on s’intéresse à la prévision météorologique ou climatique à courte échéance ou au changement climatique à plus long terme, ou que l’on parle de simulations issues des modèles de climat ou du déploiement de jumeaux numériques pour diverses applications. Le débat est aussi exacerbé en Europe en raison de l’amalgame relayé par le programme DestinE entre exascale, ultra haute résolution et jumeaux numériques. Cet amalgame occulte des discussions plus différenciées et reflétant mieux le large spectre d’activités de CLIMERI-France autour du calcul, de l’avenir de la modélisation du climat et le recours à différentes méthodes d’intelligence artificielle (fouille de données, apprentissage machine, classifications, assimilation…).

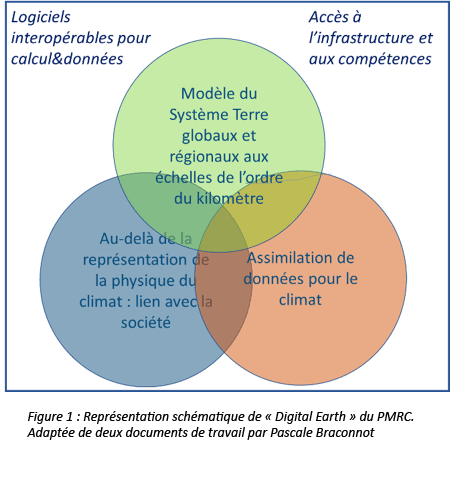

Ces débats traversent aussi la mise en place d’une des activités phares du programme mondial de recherche sur le climat (PMRC) appelé «Digital Earth» (DE). Du point de vue du PMRC, l’objectif de DE n’est pas de construire un modèle ou un jumeau numérique, mais d’offrir un lieu d’échange et de partage d’expertise autour de questions d’actualité en pleine mutation scientifique et technique. Les orientations actuelles de DE s’organisent autour de 3 principaux piliers (Figure 1).

Ces débats traversent aussi la mise en place d’une des activités phares du programme mondial de recherche sur le climat (PMRC) appelé «Digital Earth» (DE). Du point de vue du PMRC, l’objectif de DE n’est pas de construire un modèle ou un jumeau numérique, mais d’offrir un lieu d’échange et de partage d’expertise autour de questions d’actualité en pleine mutation scientifique et technique. Les orientations actuelles de DE s’organisent autour de 3 principaux piliers (Figure 1).

La modélisation couplée régionale ou globale aux échelles de l’ordre du km a comme objectif d’accroître la mise en réseau de l’expertise autour des développements des modèles du Système Terre et des composantes individuelles. L’assimilation de données vise à créer une communauté de recherche active dans le domaine du climat bénéficiant et étendant les efforts de prévision numérique du temps et de réanalyse en cours. L’intégration, au-delà du système physique des interactions avec l’activité humaine et les systèmes anthropisés ou des études d’impacts du changement climatique sur les activités humaines, alimentera la réflexion sur les systèmes d’information climatique. Un atout de «Digital Earth» est le regroupement autour de questions communes de la modélisation globale. Comme pour toutes les activités du PMRC, le succès dépendra de l’appropriation par la communauté. Il dépendra aussi de la capacité de DE à offrir à la fois de nouvelles voies d’exploration du fonctionnement du climat ou de sa prévisibilité et des réponses plus intégrées et pertinentes aux questions d’atténuation et d’adaptation aux échelles régionales et locales.

Par certains aspects, la mise en place de «Digital Earth» s’inscrit dans la demande de renforcement de la coordination des démarches autour du calcul haute performance et des données émergeant de deux « concept notes » de l’organisation mondiale de la météorologie (OMM). Ces notes ont été élaborées par des membres d’un groupe de travail mis en place par le comité recherche de l’OMM et ont fait l’objet de contributions externes sur les contenus et les relectures.

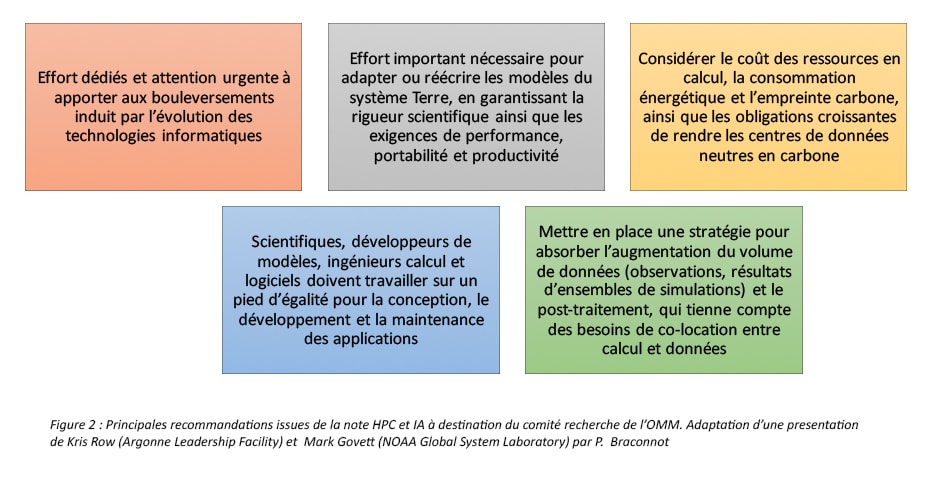

En ce qui concerne le calcul et les données (Figure 2), ces recommandations insistent sur l’urgence de mettre en place des efforts dédiés pour surmonter les difficultés liées à l’évolution des technologies informatiques dans un paysage où les orientations ne sont pas encore entièrement stabilisées. Elles insistent sur le besoin de coordination pour préparer les codes aux machines escales, en insistant sur le fait que les défis scientifiques croissants, ainsi que la complexité croissante de l'environnement informatique, nécessiteront des efforts importants pour adapter ou réécrire les modèles du système Terre et garantir que les développements remplissent les exigences de performance, de portabilité (divers matériels, y compris GPU et CPU) et de productivité. L’attention est aussi mise sur l'empreinte carbone et l’exigence de rendre les centres de données neutres en carbone dans le cadre d'engagements climatiques. La « co-conception » entre les scientifiques, les développeurs de modèles, les informaticiens et les ingénieurs en logiciels est mentionnée comme un atout et il est important d’étendre cette co-construction à l’industrie pour les questions de matériel-logiciel. Enfin, en ce qui concerne l’augmentation du volume de données et des besoins d’analyse, une co-localisation du HPC et des données est jugée nécessaire, ainsi que l’accès libre aux résultats. Ce dernier point requiert une normalisation accrue pour améliorer l'accès, la découverte et l'utilisation des données.

En ce qui concerne le calcul et les données (Figure 2), ces recommandations insistent sur l’urgence de mettre en place des efforts dédiés pour surmonter les difficultés liées à l’évolution des technologies informatiques dans un paysage où les orientations ne sont pas encore entièrement stabilisées. Elles insistent sur le besoin de coordination pour préparer les codes aux machines escales, en insistant sur le fait que les défis scientifiques croissants, ainsi que la complexité croissante de l'environnement informatique, nécessiteront des efforts importants pour adapter ou réécrire les modèles du système Terre et garantir que les développements remplissent les exigences de performance, de portabilité (divers matériels, y compris GPU et CPU) et de productivité. L’attention est aussi mise sur l'empreinte carbone et l’exigence de rendre les centres de données neutres en carbone dans le cadre d'engagements climatiques. La « co-conception » entre les scientifiques, les développeurs de modèles, les informaticiens et les ingénieurs en logiciels est mentionnée comme un atout et il est important d’étendre cette co-construction à l’industrie pour les questions de matériel-logiciel. Enfin, en ce qui concerne l’augmentation du volume de données et des besoins d’analyse, une co-localisation du HPC et des données est jugée nécessaire, ainsi que l’accès libre aux résultats. Ce dernier point requiert une normalisation accrue pour améliorer l'accès, la découverte et l'utilisation des données.

La deuxième note de l’OMM porte sur l’Intelligence artificielle et les données. Elle fait un état des lieux des nombreuses directions possibles et en cours. Elle souligne le besoin d’adopter à très court terme des stratégies cohérentes pour les produits opérationnels et les chaînes de traitement de données et, à plus long terme, de promouvoir les bonnes pratiques. De nombreuses barrières sont aussi évoquées pour l’adoption de nouvelles solutions basées sur l’IA. Parmi elles figurent les exigences liées à la forte augmentation du nombre de données. Bien que les recommandations visent plus des applications opérationnelles, les exemples fournis, les questions de flexibilité et d’interopérabilité sont pertinents pour les questions de recherche attachées à la modélisation du climat ou aux comparaisons modèles-données.

Les questions liées au HPC et à l’IA ont pris une place prépondérante dans le paysage. Un enjeu pour CLIMERI-France est de permettre de déployer une stratégie nationale cohérente et dans la durée, en bonne adéquation avec les nombreuses directions de recherches attachées à la modélisation du climat et de ses changements. Le succès du PEPR TRACCS arrive à un moment charnière pour aborder ces évolutions.

Rédactrice : P. Braconnot (LSCE-IPSL)

En savoir plus

- OMM : Organisation météorologique mondiale

- PMRC : Programme mondial de recherche sur le climat

- Activité phare PMRC- Digital Earth

Avec la fin de la loi de Moore, la performance des calculateurs augmente en agrégeant de plus en plus de cœurs, le plus souvent accompagnés de cartes graphiques (GPU) capables d’accélérer les boucles de calcul. En France, après l’IDRIS, le CINES accueille une machine composée majoritairement d’accélérateurs GPU, Adastra, dont la performance crête atteint 70 PFLOPS. Le projet Exascale France vise à équiper le centre du TGCC d’une machine exaflopique pour laquelle l’essentiel de la puissance crête proviendra d’accélérateurs GPU, dont la technologie reste encore à définir.

Ces cartes graphiques intègrent des milliers de petites unités calculs très efficaces pour traiter simultanément une même instruction sur un gros volume de données comme c’est le cas des calculs opérés par des boucles imbriquées (kernels de calcul). Ces dernières sont alors transférées (offload) du CPU (host) vers le GPU qui effectuera les calculs. Cependant, les performances chutent dès lors que trop de données sont transférées entre CPU et GPU, en raison de la latence et de la faible bande passante du bus d’interconnexion. Il est alors nécessaire de minimiser ces transferts en gardant au maximum les données sur le GPU. De ce fait, la programmation devient plus complexe.

Plusieurs approches sont possibles pour porter des codes sur GPU, allant des langages de bas niveau très intrusifs (i.e. CUDA, OpenCL, HIP), à des approches moins invasives à base de directives comme par exemple les standards ouverts openACC et OpenMP5. Pour certains codes, la réécriture complète est envisagée en s’appuyant sur des concepts faisant la séparation entre le contenu du code (équations physiques) et son exécution sur une architecture spécifique, à l’aide d’une couche d’abstraction (separation of concern), mettant en œuvre, soit des librairies de plus haut niveau (Kokkos, Raja, SYCL,…) qui pour la plupart nécessite un code écrit en C++ moderne, soit des langages dédiés à un domaine particulier (Domain Specific Language, DSL) pour le climat et la prévision du temps (PSyclone, GridTools).

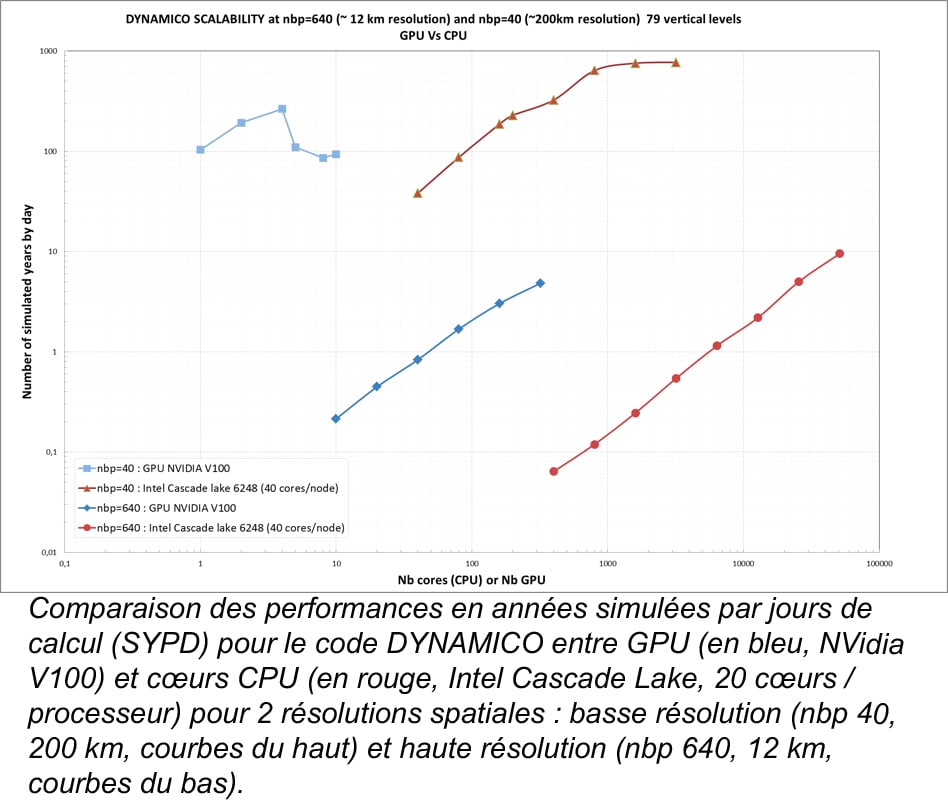

A l’IPSL, le nouveau cœur dynamique DYNAMICO a été porté en 2019 sur GPU dans le cadre du contrat de progrès de l’IDRIS (3 mois de travail pour 3 personnes). Dans ce cas précis, les résultats montrent que pour un même temps d’exécution, un GPU (NVidia V100) est 4 à 6 fois plus rapide qu’un processeur CPU Intel de même génération (Cascade Lake), suivant la résolution spatiale (pour respectivement 200 km et 12 km). Cependant, lorsque que l'on effectue des calculs parallèles sur plusieurs nœuds, l’efficacité des GPUs sature plus rapidement que celle des CPUs, car les GPUs deviennent sous alimentés en calculs pour exprimer leur plein potentiel alors qu’au contraire les CPUs deviennent plus efficaces en bénéficiant des effets de caches liés à la diminution du volume de données traitées par cœurs. On se retrouve donc avec de meilleurs temps de restitution en faveur des CPUs (voir la figure).

Néanmoins, il faut contrebalancer ce résultat en considérant le coût intégré (matériel + énergie) des 2 solutions pour un temps de restitution équivalent. En effet le rapport flop/watt est très en faveur des GPUs, mais leur coût d’achat est plus élevé, d’autant qu’en général, sur un nœud GPU sont également présents au moins 2 CPUs. Toutefois, on constate d’ores et déjà que l’efficacité des GPU est mieux exploitée à haute résolution, écart qui s’accentuera probablement avec les générations futures. Plus récemment, ce retour d’expérience a été confirmé lors de la participation en 2021 d’une équipe du LMD-IPSL à un hackathon organisé par l’IDRIS à partir d’une version simplifiée de la physique du modèle d’atmosphère, pour laquelle on obtient des résultats du même ordre.

Passer au portage sur GPU de l’ensemble du modèle couplé de l’IPSL qui comporte plusieurs codes, un plus grand nombre de lignes de codes, et des échanges importants de données, est un enjeu d’envergure. En effet, pour DYNAMICO ou la physique simplifiée, l’effort de portage n’a concerné que quelques milliers de lignes, qui sont à comparer aux près de 500 000 lignes composant l’ensemble du modèle couplé. Ce portage est d’autant plus complexe que nos modèles ont un profil de performance relativement plat, c’est-à-dire que le temps de calcul n’est pas dominé par une petite partie du code sur laquelle l’effort pourrait se concentrer. Cette adaptation des codes nécessitera également de repenser totalement l’architecture logicielle. Néanmoins cet effort est absolument nécessaire pour la réalisation de simulations à plus haute résolution ainsi et/ou de grands ensembles, car il est acté que l’essentiel de la puissance disponible des prochains super-calculateurs proviendra des accélérateurs. Le projet PEPR TRACCS va apporter un soutien important pour aborder cet enjeu.

Rédacteur : Y. Meurdesoif (LSCE-IPSL)

En savoir plus

CMIP6 : rapide bilan et préparation pour la suite

Les modèles de climat français issus de la nouvelle génération CMIP6 (IPSL-CM6A-LR et CNRM-CM6-1) sont caractérisés par deux éléments marquants qui contrastent avec les générations précédentes: (i) une forte variabilité interne (i.e. la variabilité intrinsèque non-forcée du système climatique) aux échelles de temps centennales et (ii) une forte sensibilité climatique à l'équilibre (i.e. le réchauffement de surface à l’équilibre en réponse à un doublement de la concentration en CO2). Des travaux ont été réalisés dans le but de mieux comprendre l’origine de ces changements, ainsi que les impacts associés.

La variabilité centennale de la température de surface moyenne globale des modèles de climat français est largement partagée par les modèles CMIP6 utilisant la plate-forme de modélisation océanique NEMO à 1° de résolution nominale. Cette variabilité n’était pas présente dans les précédentes générations de modèles de climat CMIP3 et CMIP5 et n’est pas présente dans la plupart des modèles de climat de l’ensemble CMIP6 [Parsons et al 2020]. Elle relève donc d’un comportement plutôt extrême de l’ensemble CMIP6. Elle est pilotée par la variabilité basse fréquence de la circulation méridienne de retournement Atlantique (AMOC). Une phase d’accélération de l’AMOC étant associée à un réchauffement dans l’Atlantique Nord, particulièrement marqué aux latitudes subpolaires, et inversement lors d’une phase de ralentissement de l’AMOC [Bonnet et al 2021, Boucher et al 2020, Voldoire et al 2019]. Les reconstructions paléoclimatiques des deux derniers millénaires questionnent le réalisme d’un tel comportement. Concernant la température moyenne globale, sa fourchette de variations à cette fréquence reste inférieure à 0.5°C dans les reconstructions, quant à l’AMOC, elle ne montre pas de variabilité centennale claire, bien que les incertitudes de mesures ne permettent pas d’exclure un tel comportement [PAGES2k Consortium, 2019 ; Caesar et al 2021]. Les mécanismes à l’origine de cette variabilité basse fréquence sont communs aux modèles de climat de l’IPSL et du CNRM et impliquent les échanges d’eau douce entre l’Arctique et l’Atlantique Nord, la stratification verticale de l’océan et l’AMOC [Jiang et al 2021, Waldman et al 2021]. L’Arctique est un réservoir d’eau douce qui se charge par l’excès de précipitation et d’apport des rivières sur l’évaporation. Périodiquement, sa circulation se referme et piège l’excès d’eau douce, réduisant les apports d’eau douce vers l’Atlantique Nord subpolaire. C’est dans cette dernière région qu’a lieu la plongée des eaux qui alimente l’AMOC. Or, l’apport réduit en eaux douces densifie les masses d’eau, intensifiant la plongée des eaux et par conséquent l’AMOC. Finalement, le transport d’eaux chaudes vers le Nord associé à l’AMOC réchauffe la surface de l’Atlantique Nord et du globe. Lorsque le flux d’eau douce depuis l’Arctique s’inverse, l’effet opposé advient et le cycle s’inverse, refroidissant la surface du globe.

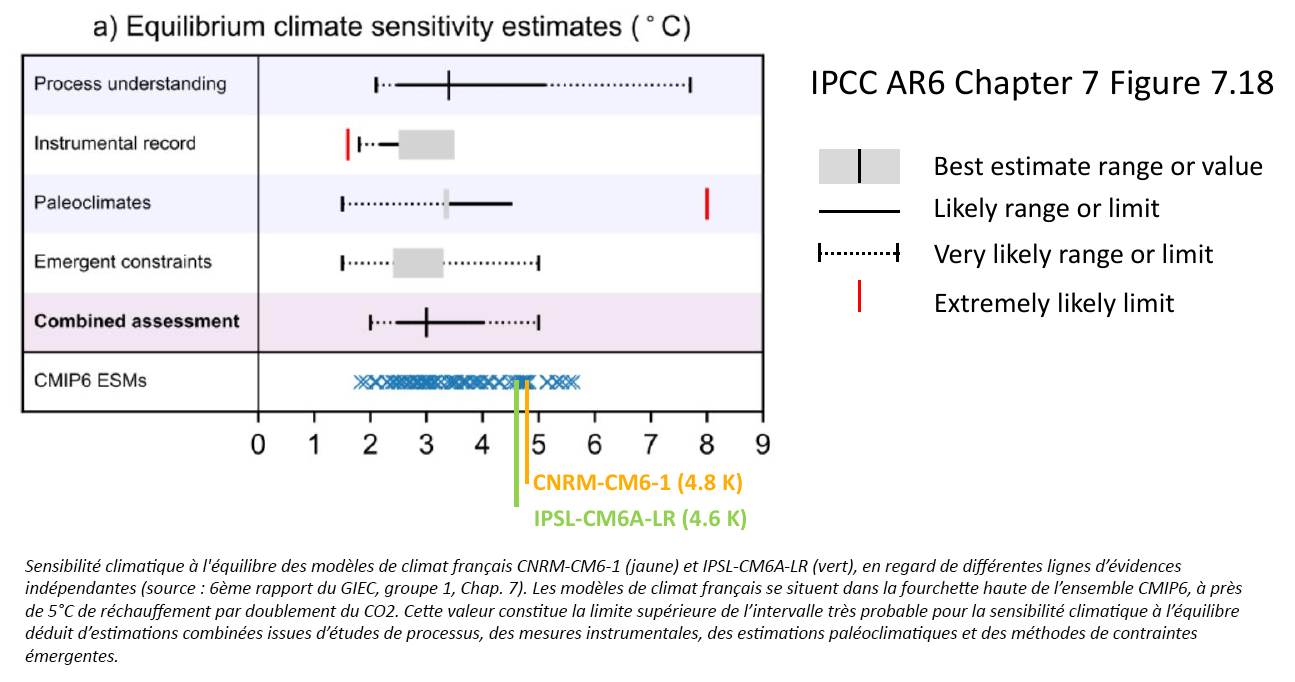

Une partie des modèles de climat de la nouvelle génération CMIP6 sont caractérisés par une plus forte sensibilité climatique que leurs homologues de la génération précédente. C’est le cas des modèles français qui ont vu leur sensibilité climatique à l’équilibre augmenter de 4.1 à 4.6°C pour le modèle IPSL et de 3.3°C à 4.8°C pour le modèle CNRM (voir figure).

Dans le cas du modèle du CNRM, cette augmentation est induite par un changement dans la réponse radiative des nuages de la composante atmosphérique du modèle qui se traduit par un renforcement de la rétroaction des nuages à la fois dans le visible (nuages bas) et l’infrarouge (nuages d’altitude), avec une part plus importante pour les nuages de haute altitude [Saint Martin et al 2021]. Un changement dans la représentation de la convection dans CNRM-CM6 par rapport à CNRM-CM5 pourrait être à l’origine de ce renforcement. Pour le modèle de l’IPSL, les principaux facteurs à l’origine de cette plus forte sensibilité climatique sont un renforcement de la rétroaction liée aux ajustements rapides troposphériques (i.e. ajustements qui interviennent immédiatement en réponse à un forçage externe avant les rétroactions climatiques découlant du réchauffement) ainsi qu’un renforcement des rétroactions combinées du gradient thermique vertical de l’atmosphère et de la vapeur d’eau [Boucher et al 2020]. Le renforcement de ces rétroactions est légèrement compensé par un affaiblissement de la rétroaction des nuages. Ces changements par rapport à IPSL-CM5 semblent dus à un changement de la physique de la convection. L’origine de cette augmentation de la sensibilité climatique est donc différente selon les modèles. En regard de l’estimation de la sensibilité climatique à l’équilibre dans le 6ème rapport du Groupe d'experts intergouvernemental sur l'évolution du climat (GIEC), réalisée en combinant différentes lignes d’évidence [Sherwood et al., 2020], les valeurs des modèles français sont supérieures à la gamme de valeur probable (66%) mais restent situées dans la gamme de valeur très probable (90%).

Dans le cas du modèle du CNRM, cette augmentation est induite par un changement dans la réponse radiative des nuages de la composante atmosphérique du modèle qui se traduit par un renforcement de la rétroaction des nuages à la fois dans le visible (nuages bas) et l’infrarouge (nuages d’altitude), avec une part plus importante pour les nuages de haute altitude [Saint Martin et al 2021]. Un changement dans la représentation de la convection dans CNRM-CM6 par rapport à CNRM-CM5 pourrait être à l’origine de ce renforcement. Pour le modèle de l’IPSL, les principaux facteurs à l’origine de cette plus forte sensibilité climatique sont un renforcement de la rétroaction liée aux ajustements rapides troposphériques (i.e. ajustements qui interviennent immédiatement en réponse à un forçage externe avant les rétroactions climatiques découlant du réchauffement) ainsi qu’un renforcement des rétroactions combinées du gradient thermique vertical de l’atmosphère et de la vapeur d’eau [Boucher et al 2020]. Le renforcement de ces rétroactions est légèrement compensé par un affaiblissement de la rétroaction des nuages. Ces changements par rapport à IPSL-CM5 semblent dus à un changement de la physique de la convection. L’origine de cette augmentation de la sensibilité climatique est donc différente selon les modèles. En regard de l’estimation de la sensibilité climatique à l’équilibre dans le 6ème rapport du Groupe d'experts intergouvernemental sur l'évolution du climat (GIEC), réalisée en combinant différentes lignes d’évidence [Sherwood et al., 2020], les valeurs des modèles français sont supérieures à la gamme de valeur probable (66%) mais restent situées dans la gamme de valeur très probable (90%).

Ces deux comportements ont des implications importantes sur l’analyse des scénarios climatiques : ils signifient une plus forte incertitude associée à la variabilité interne sur les tendances climatiques multi-décennales à centennales et une réévaluation à la hausse de la sensibilité du système climatique au forçage anthropique par les gaz à effet de serre. Etant donné leur sensibilité à la composante océanique et à la physique atmosphérique des modèles de climat, il sera essentiel de surveiller ces caractéristiques dans les prochaines générations de modèles de climat français.

Rédacteurs : R. Bonnet (IPSL) et R. Waldman (Météo-France)

En savoir plus

- CMIP6 : Coupled Model Intercomparison Project Phase 6

- NEMO : Nucleus for European modelling of the ocean

- 6ème rapport du Groupe d'experts intergouvernemental sur l'évolution du climat

Références

- Bonnet, R., Swingedouw, D., Gastineau, G., Boucher, O., Deshayes, J., Hourdin, F., ... & Sima, A. (2021). Increased risk of near term global warming due to a recent AMOC weakening. Nature communications, 12(1), 1-9, https://doi.org/10.1038/s41467-021-26370-0

- Boucher, O., Servonnat, J., Albright, A. L., Aumont, O., Balkanski, Y., Bastrikov, V., ... & Vuichard, N. (2020). Presentation and evaluation of the IPSL‐CM6A‐LR climate model. Journal of Advances in Modeling Earth Systems, 12(7), https://doi.org/10.1029/2019MS002010

- Caesar, L., McCarthy, G. D., Thornalley, D. J. R., Cahill, N., & Rahmstorf, S. (2021). Current Atlantic meridional overturning circulation weakest in last millennium. Nature Geoscience, 14(3), 118-120, https://doi.org/10.1038/s41561-021-00699-z

- Jiang, W., Gastineau, G., & Codron, F. (2021). Multicentennial variability driven by salinity exchanges between the atlantic and the arctic ocean in a coupled climate model. Journal of Advances in Modeling Earth Systems, 13(3), https://doi.org/10.1029/2020MS002366

- PAGES 2K Consortium (2019). Consistent multidecadal variability in global temperature reconstructions and simulations over the Common Era. Nat. Geosci. 12, 643–649 (2019). https://doi.org/10.1038/s41561-019-0400-0

- Parsons, L. A., Brennan, M. K., Wills, R. C., & Proistosescu, C. (2020). Magnitudes and spatial patterns of interdecadal temperature variability in CMIP6. Geophysical Research Letters, https://doi.org/10.1029/2019GL086588

- Saint‐Martin, D., Geoffroy, O., Voldoire, A., Cattiaux, J., Brient, F., Chauvin, F., ... & Valcke, S. (2021). Tracking changes in climate sensitivity in CNRM climate models. Journal of Advances in Modeling Earth Systems, 13(6), e2020MS002190, https://doi.org/10.1029/2020MS002190

- Sherwood, S. C., Webb, M. J., Annan, J. D., Armour, K. C., Forster, P. M., Hargreaves, J. C., ... & Zelinka, M. D. (2020). An assessment of Earth's climate sensitivity using multiple lines of evidence. Reviews of Geophysics, 58(4), https://doi.org/10.1029/2019RG000678

- Voldoire, A., Saint‐Martin, D., Sénési, S., Decharme, B., Alias, A., Chevallier, M., ... & Waldman, R. (2019). Evaluation of CMIP6 deck experiments with CNRM‐CM6‐1. Journal of Advances in Modeling Earth Systems, 11(7), 2177-2213, https://doi.org/10.1029/2019MS001683

- Waldman, R., Hirschi, J., Voldoire, A., Cassou, C., & Msadek, R. (2021). Clarifying the relation between AMOC and thermal wind: application to the centennial variability in a coupled climate model. Journal of Physical Oceanography, 51(2), 343-364, https://doi.org/10.1175/JPO-D-19-0284.1

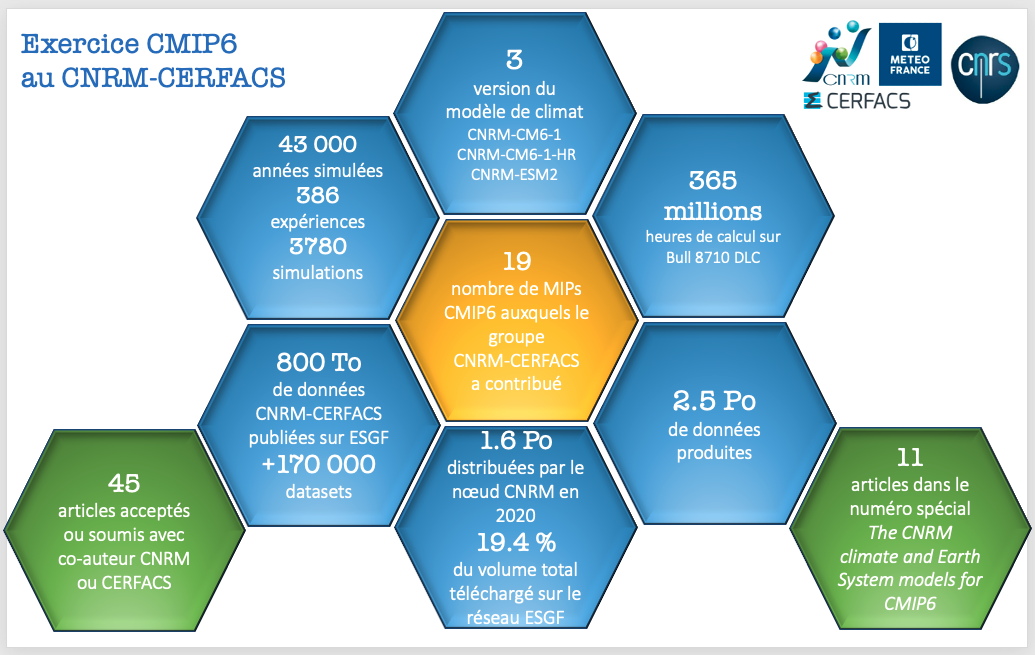

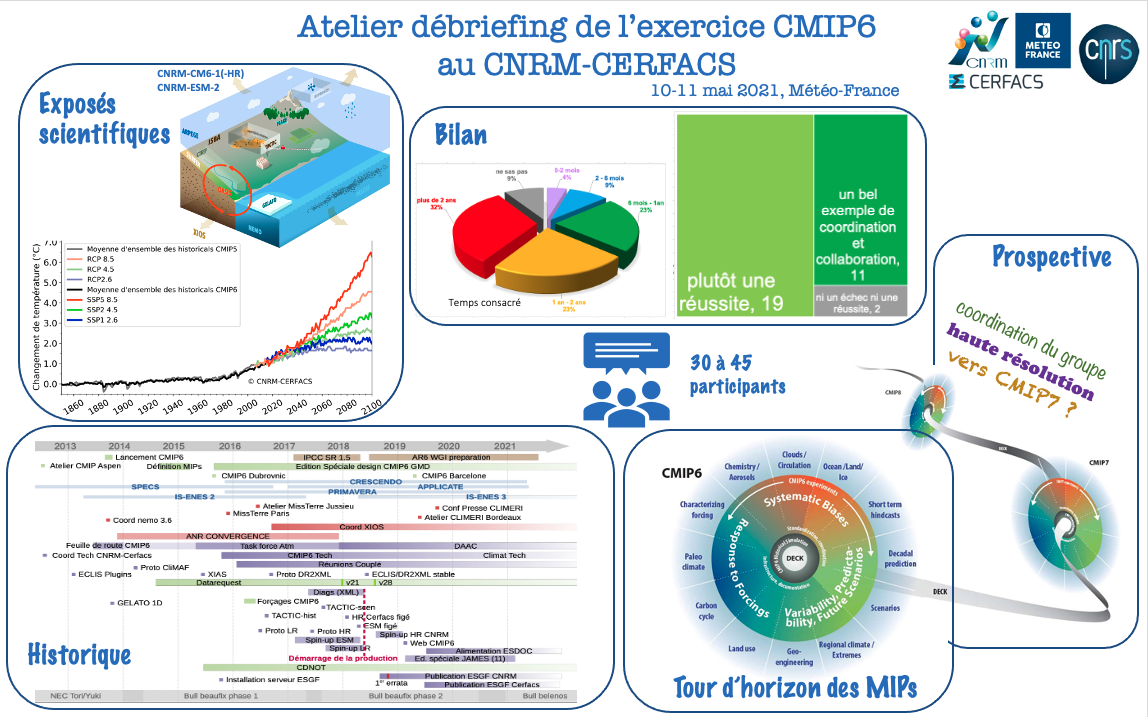

Le CNRM et le Cerfacs ont contribué à l’exercice CMIP6 via la production et l’analyse de simulations avec le modèle CNRM-CM, décliné en 3 versions, CNRM-CM6-1, le coeur physique à résolution standard (~1°), CNRM-ESM2-1, le modèle de système Terre à la même résolution et CNRM-CM6-1-HR, la version haute résolution du coeur physique (50km pour l’atmosphère, 1/4° pour l’océan). Les deux laboratoires ont partagé le développement du modèle et la réalisation des simulations CMIP6. Le groupe a ainsi participé à 19 MIPs de CMIP6, réalisant 3780 simulations et a publié 1,6 Po de données sur son nœud ESGF sur les 2,5 Po produites1. Le travail de mise au point des composantes du modèles a été décrit dans 11 papiers publiés dans une édition spéciale « The CNRM climate and Earth System models for CMIP6 » dans Journal of Advances in Modeling Earth Systems. Les chercheurs du groupe ont également publié plus de 45 papiers1 basés sur l’analyse des simulations produites.

Ce bilan chiffré est le fruit d’un travail de longue haleine qui a débuté à l’automne 2012, soit juste après la publication des données pour la précédente phase de CMIP. Dès le début 2013, le groupe s’était accordé sur une feuille de route pour CMIP6. De nombreux développements ont été menés depuis cette date, en particulier un grand chantier autour de la composante atmosphérique ARPEGE dans laquelle un nouvel ensemble de paramétrisations de la physique atmosphérique a été activé. Les éléments constitutifs de la version ciblée avaient été choisis mais les différentes étapes de calibration ont nécessité plus de 3 années. En parallèle de nombreux développements techniques ont permis de fluidifier la phase de production finale. L’intégration d’XIOS pour gérer les données produites par toutes les composantes du modèle on-line a été un pilier du nouveau « workflow ». La gestion des données produites a été également facilitée par le développement de l’outil DR2XML qui est à l’interface entre XIOS et la « Data Request » CMIP6, cette dernière définissant les variables à produire pour chaque simulation. Depuis 2011 (CMIP5), le groupe CNRM-Cerfacs est doté d’un serveur ESGF, qui a été maintenu et upgradé tout au long de CMIP6, ce qui a permis de maîtriser le cycle de la donnée de bout en bout.

Ce bilan chiffré est le fruit d’un travail de longue haleine qui a débuté à l’automne 2012, soit juste après la publication des données pour la précédente phase de CMIP. Dès le début 2013, le groupe s’était accordé sur une feuille de route pour CMIP6. De nombreux développements ont été menés depuis cette date, en particulier un grand chantier autour de la composante atmosphérique ARPEGE dans laquelle un nouvel ensemble de paramétrisations de la physique atmosphérique a été activé. Les éléments constitutifs de la version ciblée avaient été choisis mais les différentes étapes de calibration ont nécessité plus de 3 années. En parallèle de nombreux développements techniques ont permis de fluidifier la phase de production finale. L’intégration d’XIOS pour gérer les données produites par toutes les composantes du modèle on-line a été un pilier du nouveau « workflow ». La gestion des données produites a été également facilitée par le développement de l’outil DR2XML qui est à l’interface entre XIOS et la « Data Request » CMIP6, cette dernière définissant les variables à produire pour chaque simulation. Depuis 2011 (CMIP5), le groupe CNRM-Cerfacs est doté d’un serveur ESGF, qui a été maintenu et upgradé tout au long de CMIP6, ce qui a permis de maîtriser le cycle de la donnée de bout en bout.

L’ensemble de ces développements ont été soutenus par de nombreux projets nationaux (ANR Convergence, LEFE MissTerre) et européens. Il est à noter que le calendrier imposé par ces projets a parfois été problématique, n’étant pas toujours en phase avec la réalité du calendrier CMIP6, la définition des forçages à utiliser et de la Data Request ayant été figée très tardivement. Le groupe a cependant réussi à réaliser les simulations de spin-up courant 2017 et a publié ses premières simulations en juillet 2018, CNRM-CM6-1 étant ainsi un des premiers modèles publiés sur ESGF pour CMIP6. Le groupe a réussi à maintenir son calendrier dans un contexte où le calculateur utilisé pour réaliser les simulations a constamment évolué, ce qui a nécessité des phasages successifs contraignants.

Suite à cet effort collectif important, le groupe a réalisé une enquête interne pour sonder les participants sur leur ressenti à l’issue de l’exercice CMIP6. Environ 35 ingénieurs et chercheurs du groupe CNRM-CERFACS ont contribué à CMIP6. Le degré d’implication de chacun a été très variable (de quelques mois à plus de 2 ans de travail individuellement) avec un total cumulé représentant environ 38 personnes mois. Le sentiment de réussite et le caractère motivant de l’aventure collective sont largement partagés même si l’exercice est considéré comme ayant été complexe, chronophage et, pour beaucoup, usant. En ce qui concerne nos modèles, les chercheurs retiennent le succès de la stratégie de développement des 3 versions de modèle “sans couture” et la complémentarité des versions CM et ESM qui ont chacun un coût de temps de calcul relativement faible en regard de leur complexité et de leur résolution. Notre modèle est également vu comme bon et robuste et la composante surface continentale est considérée comme la plus avancée par rapport à l’état de l’art. On retient aussi la singularité de ce modèle qui présente une forte sensibilité climatique à l’équilibre tandis que sa sensibilité climatique en régime transitoire reste faible et compatible avec les tendances récentes. Les chercheurs mettent aussi en avant de nombreuses déficiences, souvent en lien avec leur propre domaine de recherche (mauvaise représentation de la banquise, de la mousson africaine, forte variabilité, problèmes de conservation d’énergie, etc).

L’enquête interne a aussi abordé des questions prospectives, il en ressort que l’exercice CMIP est inscrit dans l’ADN de notre groupe, qu’il constitue un temps fort et fédérateur et qu’il reste encore beaucoup de travail pour exploiter scientifiquement les simulations produites. A l’avenir, il est identifié qu’il faudra veiller à bien soutenir nos axes de travail privilégiés (grands ensembles, physique perturbée, et sensibilité aux incertitudes des forçages). Le développement d’une version à très haute résolution est considéré comme prématuré pour travailler sur le climat mais reste une piste potentiellement intéressante pour l’étude de certains processus. Il y a un consensus sur le fait qu’augmenter la résolution ne garantit pas une nette amélioration de la qualité des modèles et qu’un tel développement demanderait un travail considérable sur la physique que le groupe ne semble pas prêt à soutenir actuellement.

Il existe aussi un consensus sur le besoin de mieux structurer la coordination des deux laboratoires autour de l’activité de modélisation globale. Les premières actions menées à la suite de ce bilan ont donc consisté à lancer une concertation pour repenser cette coordination, puis à mettre en place une nouvelle organisation qui devrait nous permettre de mieux aborder les futures échéances. Enfin, plusieurs points de vigilance ont été soulevés : notre dépendance à des codes communautaires et à leur adaptation aux nouvelles architectures, le besoin d’outils communs et enfin la pérennité du système ESGF et plus généralement de l’hébergement et de la distribution des données produites. Sur ces points l’infrastructure CLIMERI apparaît comme un cadre important pour soutenir l’effort collectif et les outils communautaires.

1 chiffres de mai 2021

Rédactrice : A. Voldoire (CERFACS) et M.-P. Moine (CERFACS)

En savoir plus

L’exercice international d’intercomparaison de modèles climatiques couplés CMIP6 a permis de produire un nouvel ensemble de simulations de taille inédite pour s’interroger sur le fonctionnement du climat et la façon dont il est perturbé par les activités humaines. Cet ensemble a fait l’objet de nombreuses analyses et publications scientifiques. Les résultats ont alimenté le 6ème rapport d’évaluation du GIEC et ce nouveau jeu de données contribue à de nouveaux services climatiques. Lors de la 24ème session du WGCM1, qui s’est tenue en distantiel début décembre 2021, les différents groupes de modélisation ayant contribué à CMIP6 ont été invités à faire leurs premiers retours sur l’exercice. Certains points ont fait consensus, à savoir :

- l’importance de CMIP6 pour la communauté de recherche sur le climat

- la fierté d’avoir relevé un défi, mais également

- le fait que l’exercice soit difficile à réaliser et très lourd. En particulier, les retours des groupes de modélisation sont unanimes sur la lourdeur de la « Data Request », qui définit la demande de sorties de données de l’ensemble des simulations. Cela a motivé de lancement d’une réflexion par le WIP (WGCM Infrastructure Panel) dès le mois de mars 2022.

Concernant le prochain CMIP, le sentiment général est que, sur le plan scientifique, beaucoup reste à faire pour exploiter CMIP6 et qu’il n’y a pas d’urgence de lancer un nouvel exercice d’aussi grande envergure.

La communauté contribuant à CMIP est plus partagée sur d’autres points. En particulier, la question du phasage de CMIP7 avec le prochain rapport du GIEC est de nouveau posée. En faisant l’hypothèse d’une publication du 7ème rapport d’évaluation en 2029-2030, il apparaît qu’un tel phasage imposerait de produire les simulations de CMIP7 en 2025-2026, ce qui laisserait peu de temps pour développer de nouvelles versions de modèles, en particulier pour certains groupes qui se verraient contraints de mener dans le même temps un effort pour migrer leurs codes vers une nouvelle architecture informatique telle que le GPU. Jusqu’à présent, CMIP a gardé un équilibre entre les besoins pour les questions de recherche en amont et les besoins pour les questions sociétales liées au changement climatique. Certains groupes souhaiteraient que CMIP7 soit davantage orienté vers les besoins sociétaux, en particulier via les services climatiques. Pour cela, des acteurs plus directement tournés vers les impacts, la vulnérabilité, l’adaptation et l’atténuation du changement climatique devraient être davantage associés à la définition de l’exercice, ce qui pourrait aussi contribuer à faire émerger de nouvelles questions scientifiques. La question d’inclure un volet opérationnel plus important dans CMIP fait également débat, d’autant plus que l’exercice repose en partie sur des groupes académiques. Cela pourrait, par exemple, consister à produire des simulations du climat futur plus fréquemment ou plus ciblées sur un aspect, notamment afin d’y adosser des services climatiques. La place des émulateurs dans la production de sorties climatiques pour CMIP reste ouverte et est vue comme un moyen de mieux interagir avec de nombreux acteurs de la société. Dans le but d’affiner les premiers retours, un sondage a été proposé début 2022 aux groupes de modélisation impliqués dans CMIP, mais aussi à des utilisateurs, des fournisseurs de données et des décideurs. Il s’agit ainsi de préciser les aspects positifs - et moins positifs - de CMIP6 (structure, Input4MIPs, ESGF, documentation, etc.) et recueillir les avis sur les objectifs et les priorités de CMIP7, et son organisation. Les réponses sont en cours d’analyse par le panel CMIP du WGCM et feront l’objet d’une restitution dans les mois à venir.

Les phases suivantes de CMIP bénéficieront de l’appui de l’International Project Office (IPO), qui a été récemment mis en place sur le campus de l’ESA à Harwell (Royaume-Uni). Les missions de cette structure consisteront principalement en du soutien technique et des actions de communication. En attendant la mise en place de CMIP7, une extension de CMIP6, dite CMIP6+, est envisagée. Les changements de structure par rapport à CMIP6 seraient limités, mais quelques nouveaux MIPs (projets d’intercomparaisons liés à CMIP) pourraient apparaître, selon les besoins de la communauté, comme ce fut le cas précédemment pour ZECMIP (Zero Emissions Commitment MIP) et CovidMIP. L’une des nouveautés de CMIP6+ serait de proposer une mise à jour des forçages. Notamment, les jeux de forçages historiques de CMIP6, qui se terminent en 2014 seraient, dans un premier temps, étendus au moins jusqu’en 2021, puis régulièrement mis à jour, possiblement tous les ans. L’un des bénéfices attendus de cette opérationnalisation sera pour la communauté de disposer de jeux de forçages validés au moment de réaliser des simulations CMIP7. Le jeu de forçages pourrait être complété par de nouvelles données de forçage pour la représentation du cycle de l’azote et des isotopes de l’eau. À l’avenir CMIP devrait rester une activité phare du PMRC et trouver une bonne place dans les activités du groupe de travail WGCM sur la modélisation couplée de ESMO (Earth System Model and Observations), qui regroupe les activités autour de la modélisation et des données dans la nouvelle feuille de route du PMRC.

Les phases suivantes de CMIP bénéficieront de l’appui de l’International Project Office (IPO), qui a été récemment mis en place sur le campus de l’ESA à Harwell (Royaume-Uni). Les missions de cette structure consisteront principalement en du soutien technique et des actions de communication. En attendant la mise en place de CMIP7, une extension de CMIP6, dite CMIP6+, est envisagée. Les changements de structure par rapport à CMIP6 seraient limités, mais quelques nouveaux MIPs (projets d’intercomparaisons liés à CMIP) pourraient apparaître, selon les besoins de la communauté, comme ce fut le cas précédemment pour ZECMIP (Zero Emissions Commitment MIP) et CovidMIP. L’une des nouveautés de CMIP6+ serait de proposer une mise à jour des forçages. Notamment, les jeux de forçages historiques de CMIP6, qui se terminent en 2014 seraient, dans un premier temps, étendus au moins jusqu’en 2021, puis régulièrement mis à jour, possiblement tous les ans. L’un des bénéfices attendus de cette opérationnalisation sera pour la communauté de disposer de jeux de forçages validés au moment de réaliser des simulations CMIP7. Le jeu de forçages pourrait être complété par de nouvelles données de forçage pour la représentation du cycle de l’azote et des isotopes de l’eau. À l’avenir CMIP devrait rester une activité phare du PMRC et trouver une bonne place dans les activités du groupe de travail WGCM sur la modélisation couplée de ESMO (Earth System Model and Observations), qui regroupe les activités autour de la modélisation et des données dans la nouvelle feuille de route du PMRC.

1 Working Group on Coupled Modelling (WGCM), qui est l’un des groupes de travail du PMRC (Programme Mondial de Recherche sur le Climat, World Climate Research Programme (WCRP) en anglais).

Rédacteurs : D. Salas y Melia (Météo-France), P. Braconnot (LSCE-IPSL)

En savoir plus

Les. nouveaux projets européens

ESM2025 (Earth System Models for the future) est un projet de recherche européen sur la modélisation numérique du système Terre, coordonné par Roland Séférian au Centre National de Recherches Météorologiques, CNRM (Météo-France - CNRS). Le projet a démarré le 1er juin 2021. Il est financé à hauteur de 11,3 M€ par le programme H2020 de la Commission Européenne pour une durée de 4 ans.

Fort d’une équipe internationale de 20 organismes européens (représentant 7 pays européens : Autriche, Belgique, France, Allemagne, Norvège, Suède, Suisse et Royaume-Uni) et d'une université australienne, le projet vise à développer la prochaine génération de modèles du système terrestre (ESM).

Cette nouvelle génération de modèles vise à fournir de meilleures projections climatiques permettant de contribuer à élaborer des stratégies d'atténuation et d'adaptation ambitieuses et réalistes, conformes avec les engagements de l'Accord de Paris.

Plus précisément, ESM2025 a pour objectif de développer cette nouvelle génération d’ESM par :

- l'intégration de nouvelles composantes ;

- une meilleure prise en compte des interactions et des couplages entre les composantes ;

- une meilleure représentation des processus climatiques clés grâce à des méthodes d'apprentissage automatique (intelligence artificielle) et l'utilisation d’observations.

Pour lire l'intégralité de la plaquette ESM2025, cliquez ici.

Rédacteur : R. Séférian (Météo-France)

En savoir plus

- Plaquette ESM2025

- ESM2025 : Earth System Models for the future

- CNRM : Centre National de Recherches Météorologiques